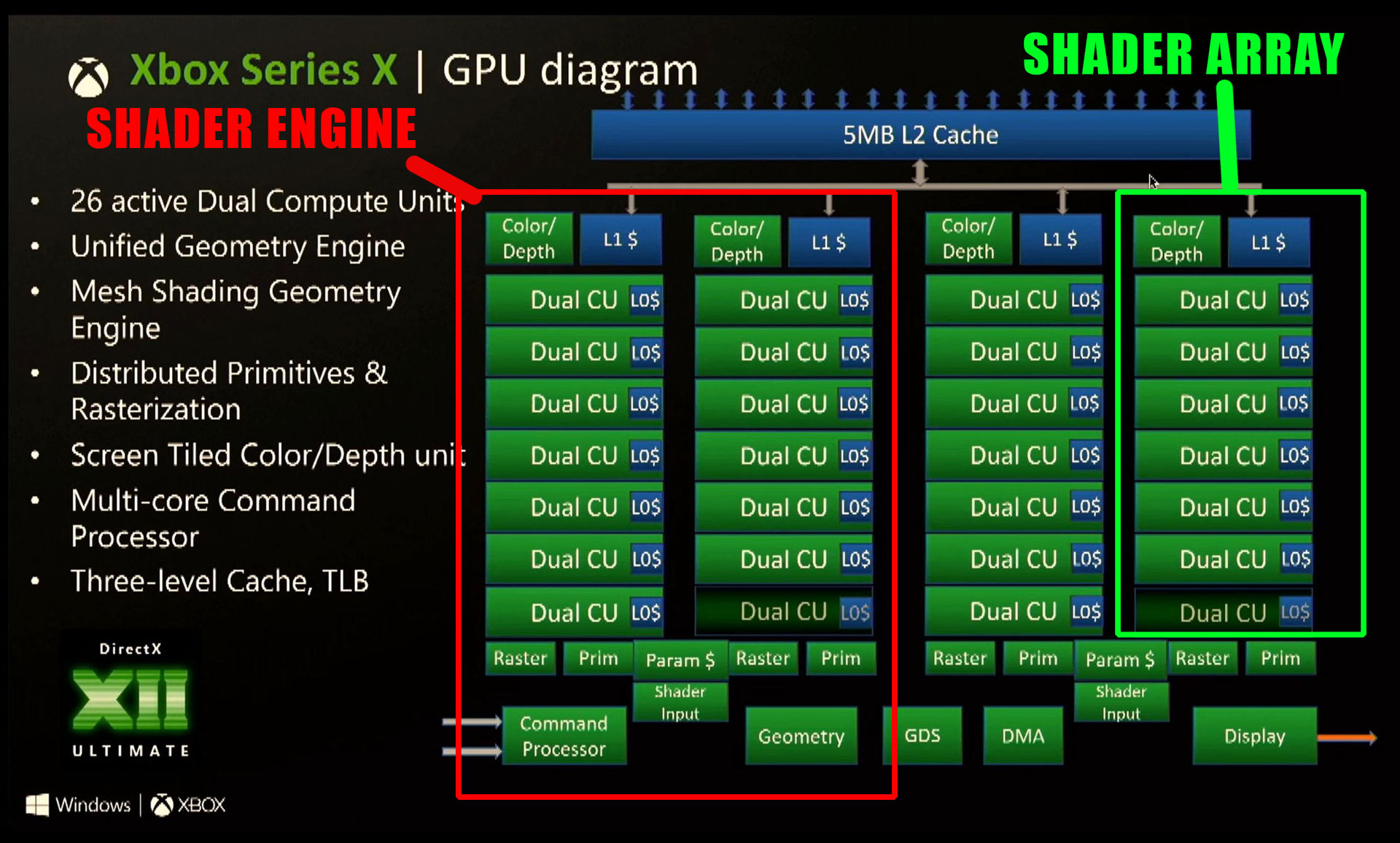

Hier mal eine Grundlagen-Prognose für die nächsten Monate, oder vielleicht sogar 2-3 Jahre des Pixelzähler-Threads. Der Matt in den Foren-Screenshots dürfte Matt Harget sein, Ex-Playstation-Entwickler und jetzt bei Roblox. Ich denke die Einschätzung ist sehr stichhaltig und wir können uns darauf gefasst machen, dass die Unterschiede in den kommenden Jahren zwischen XSX und PS5 bis auf wenige Ausreißer oder 1st-Party Titel die hervorstechen nur marginal sein werden. Noch einmal deutlich geringer als wir es von PS3/360, XBox One und PS4 und PS4 Pro und XBox One X schon kennen.

Matt Harget hatte anscheinend auch schon mit quasi allen Prognosen zu XBox One und PS4 richtig gelegen.

Schwere Zeiten für DF - statt 200% bis 400% Zoom, werden sie wohl 800% brauchen und die mittleren Abweichungen bei den FPS werden wohl oft nur im 1-stelligen %-Bereich liegen.

Andererseits, wenn sie Vergleiche von Konsolen- zu PC-Versionen machen, dann könnte es fast egal sein ob sie XSX oder PS5 nehmen.

Könnte echt langweilig und ruhig werden hier, wenn die Unterschiede "egal" im Sinne von marginal sein werden. Oder die PCMR übernimmt den thread.

https://www.neogaf.com/threads/next...leaks-thread.1480978/page-3957#post-261147689

Matt Harget hatte anscheinend auch schon mit quasi allen Prognosen zu XBox One und PS4 richtig gelegen.

Schwere Zeiten für DF - statt 200% bis 400% Zoom, werden sie wohl 800% brauchen und die mittleren Abweichungen bei den FPS werden wohl oft nur im 1-stelligen %-Bereich liegen.

Andererseits, wenn sie Vergleiche von Konsolen- zu PC-Versionen machen, dann könnte es fast egal sein ob sie XSX oder PS5 nehmen.

Könnte echt langweilig und ruhig werden hier, wenn die Unterschiede "egal" im Sinne von marginal sein werden. Oder die PCMR übernimmt den thread.

https://www.neogaf.com/threads/next...leaks-thread.1480978/page-3957#post-261147689